Боевое применение ИИ-систем Израилем в секторе Газа: этические проблемы

Вход

Авторизуйтесь, если вы уже зарегистрированы

(Голосов: 17, Рейтинг: 4.53) |

(17 голосов) |

Генеральный директор ООО «ЕС-лизинг софт», MBA ITIL

К.э.н., доцент, советник генерального директора ООО «ЕС-лизинг софт»

Опыт военных операций, ранее проводимых Армией обороны Израиля (ЦАХАЛ) в секторе Газа, поставил перед военной разведкой проблему быстрого и надежного уточнения и расширения перечня новых целей для ударов ВВС. Решая эту весьма специфическую проблему боевого планирования и реалистично оценивая перспективы обработки гигантского объема накапливаемых разведывательных данных стандартными методами анализа, в ЦАХАЛ решили сделать ставку на замену человека системами искусственного интеллекта (ИИ-системами). ИИ-системы должны были решать вопросы автоматического определения и ранжирования объектов враждебной активности в целях повышении скорости принятия решений по идентификации их как целей с последующим гарантированным поражением.

Вдохновленная успешным началом боевого применения ИИ-систем израильская военная разведка помимо выбора целей стала использовать искусственный интеллект и в прогнозной разведывательной аналитике. Считая, что подобные технологии дают возможность достаточно точного предсказания будущего, израильтяне по результатам их работы стали формировать разведывательные оценки намерений ХАМАС.

Но надежды на безграничные возможности «искусственного разума» и уверенность в своем технологическом превосходстве в последствии сыграли с ними очень злую шутку. Ведь, как показали дальнейшие события, при использовании ИИ-систем необходимо заранее понимать и учитывать возможные серьезные объективные и субъективные ограничения, возникающие при применении подобных технологий на практике.

Как уже говорилось выше, после несомненных военных успехов, связанных с применением ИИ-систем во время боевых действий, ЦАХАЛ стала чрезмерно полагаться на компьютерные алгоритмы в решении оперативных и аналитических разведывательных задач. Еще одной серьезной субъективной ошибкой израильтян стало излишне подробное описание технологий работы ИИ-систем в открытых источниках.

После 7 октября 2023 г. ИИ-система Lavender стала играть главную роль в планировании авиационных ударов по Газе, так как в рамках проведения операции «Железные мечи», было принято весьма субъективное политическое решение о распространении статуса «цели» на всех членов военного крыла ХАМАС в независимости от их ранга в организации. Все это как минимум на два порядка расширило перечень потенциальных целей для авиаударов и окончательно сделало невозможным обработку целей традиционными человеческими методами.

Причем участие человека было сведено к минимуму не только в процессе идентификации цели, но и в контрольной функции подтверждения выбранных ИИ-системой целей. Отобранные цели стали получать санкцию на удар по их уничтожению без дополнительной оценки аналитиком разведки результатов работы алгоритмов искусственного интеллекта, без изучения и верификации исходных разведывательных данных, на которых эти логические выводы были построены, и без ранее необходимого согласования сотрудника военно-юридической службы.

Для эффективного обучения и валидации ИИ-модели необходимы высококачественные наборы данных и отдельный независимый набор данных для её тестирования. А вот с этим уже изначально были большие объективные проблемы.

Разрешение на автоматическое включение Lavender людей в список целей на ликвидацию, ранее использовавшееся только в качестве вспомогательного инструмента, было получено после того, как сотрудники разведки «вручную» проверили точность случайной выборки из нескольких сотен целей, выбранных ИИ-системой. Когда выборка показала, что результаты Lavender достигли 90% точности в определении принадлежности человека к ХАМАС, было санкционировано её широкомасштабное применение. С этого момента, если система решала, что, то или иное лицо — боевик ХАМАС, то он без дополнительной проверки включался в «расстрельный список». А как только кто-то из включенных с список оказывался дома, то он сразу становился целью для авиаудара.

В результате ЦАХАЛ, особенно в первые недели конфликта, не колеблясь наносила ракетно-бомбовые удары по жилым домам, что приводило к гибели тысячи палестинцев, большинство из которых составляли мирные жители, не участвовавшие в боевых действиях, в первую очередь — женщины и дети.

Использование алгоритмов искусственного интеллекта в разведывательной деятельности оправдано ровно настолько, насколько достоверны и прозрачны для проверки исходные данные и алгоритмы, используемые для их обработки. Но если аналитики разведки и разработчики ИИ вовремя не выявили рубежные ограничения технологии или допустили внесение в алгоритм изначально ошибочных аналитических методологий, то те же самые проблемы возникнут в последствии и у разведывательного продукта, создаваемого с помощью искусственного интеллекта.

Целенаправленная политика по развитию в Израиле технологий искусственного интеллекта (ИИ) ведется давно. Уже в 2010 г. израильский премьер-министр Биньямин Нетаньяху назначил генерал-майора (в отставке) и по совместительству профессора Тель-Авивского университета Исаака Бен-Исраэля руководителем национального кибернетического проекта.

В феврале 2023 г. с участием более 60 стран в Гааге прошла первая международная конференция по ответственному использованию искусственного интеллекта в военной области REAIM, созванная по инициативе Нидерландов и Южной Кореи. По итогам саммита его участники подписали петицию о том, что представляемые ими страны, выражают приверженность использованию ИИ в соответствии с международным правом, не подрывая принципов «международной безопасности, стабильности и подконтрольности». Израиль подписывать эту декларацию отказался.

Опыт военных операций, ранее проводимых Армией обороны Израиля (ЦАХАЛ) в секторе Газа, поставил перед военной разведкой проблему быстрого и надежного уточнения и расширения перечня новых целей для ударов ВВС [1].

Решая эту весьма специфическую проблему боевого планирования и реалистично оценивая перспективы обработки гигантского объема накапливаемых разведывательных данных стандартными методами анализа, в ЦАХАЛ решили сделать ставку на замену человека системами искусственного интеллекта (ИИ-системами). ИИ-системы должны были решать вопросы автоматического определения и ранжирования объектов враждебной активности в целях повышении скорости принятия решений по идентификации их как целей с последующим гарантированным поражением.

В рамках поставленной задачи подразделением 8200 [2] был разработан ряд уникальных алгоритмов ИИ-системы The Gospel (ивр. Habsora — Евангелие), ИИ-модель [3] которой использовала для своего обучения огромные информационные массивы необработанных разведывательных данных, собранные в ходе многолетних наблюдений за территорией и населением Газы. Полный перечень данных, использованных при обучении The Gospel точно неизвестен. Однако, по мнению экспертов, системы поддержки принятия решений на основе искусственного интеллекта для целеуказания, как правило, анализируют большие информационные массивы (коллекции) из различных источников, таких как данные биллинга, перехваченные звуковые и текстовые сообщения, записи систем видеонаблюдения, съемки с беспилотников и спутников, а также данные, полученные в результате мониторинга движений и моделей поведения отдельных лиц и больших групп. По некоторым оценкам Газа — это самое фотографируемое место на планете, где каждый квадратный метр снимается с периодичностью раз в десять минут [4].

Впервые потенциал ИИ-системы The Gospel был весьма успешно применён против ХАМАС в мае 2021 г. в коротком, но весьма ожесточенном 11-дневном конфликте, известном, как операция «Страж стен». Практика применения The Gospel показала, что после интеграции ИИ-системы в планирование боевых операций ЦАХАЛ процесс выбора целей значительно ускорился. В частности, когда высокопоставленные члены ХАМАС скрылись в подземных туннелях и во многом стали менее уязвимыми, использование The Gospel позволило израильтянам быстро сориентироваться и начать атаковать значительное количество дополнительных целей — боевиков более низкого звена. По словам экс-начальника Генерального штаба Армии обороны Израиля Авива Кохави, если до введения в строй ИИ-системы в Газе удавалось выявлять и маркировать порядка 50 целей в год, то во время операции «Страж стен» The Gospel генерировала до 100 целей в день, причем около половины из них были атакованы. И это при том, что воинское подразделение, эксплуатирующее системы искусственного интеллекта насчитывало всего около сотни солдат и офицеров.

Вдохновленная успешным началом боевого применения ИИ-систем израильская военная разведка помимо выбора целей стала использовать искусственный интеллект и в прогнозной разведывательной аналитике. Считая, что подобные технологии дают возможность достаточно точного предсказания будущего, израильтяне по результатам их работы стали формировать разведывательные оценки намерений ХАМАС.

Но надежды на безграничные возможности «искусственного разума» и уверенность в своем технологическом превосходстве в последствии сыграли с ними очень злую шутку. Ведь, как показали дальнейшие события, при использовании ИИ-систем необходимо заранее понимать и учитывать возможные серьезные объективные и субъективные ограничения, возникающие при применении подобных технологий на практике.

Как уже говорилось выше, после несомненных военных успехов, связанных с применением ИИ-систем во время боевых действий, ЦАХАЛ стала чрезмерно полагаться на компьютерные алгоритмы в решении оперативных и аналитических разведывательных задач. Еще одной серьезной субъективной ошибкой израильтян стало излишне подробное описание технологий работы ИИ-систем в открытых источниках. Причем по мнению бывшего сотрудника военной разведки США Скотта Риттера результаты этих рекламных действий были достаточно прогнозируемыми.

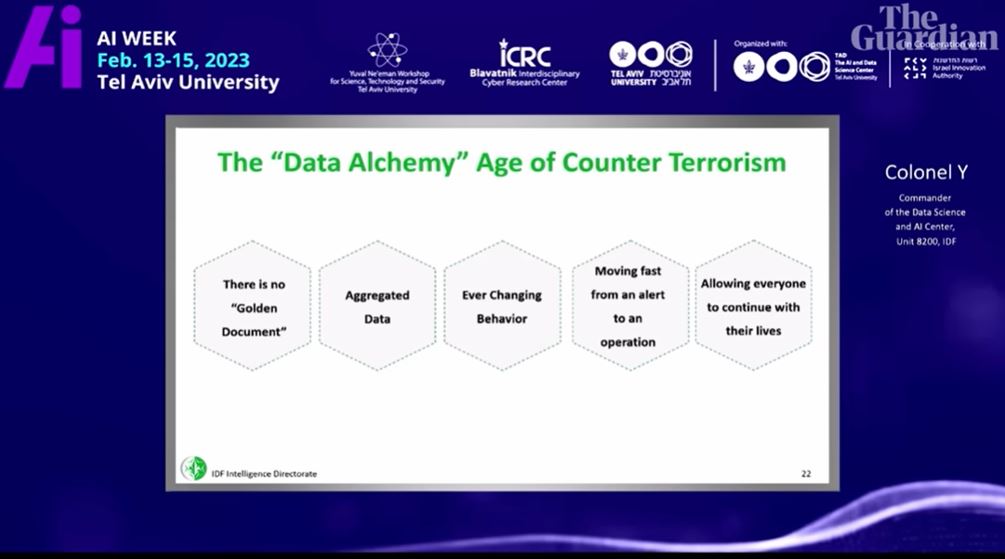

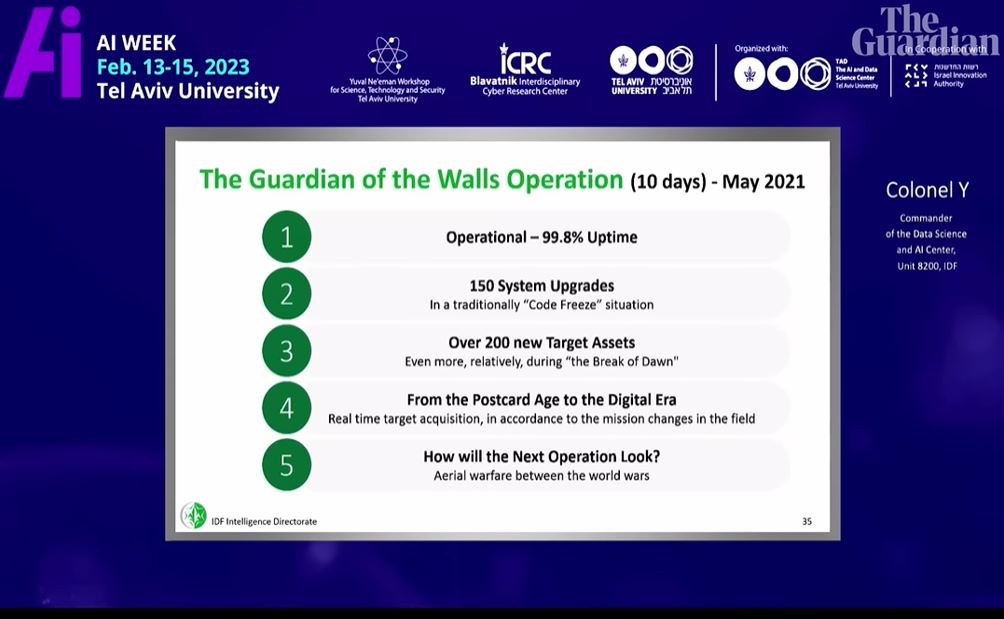

В феврале 2023 г., в ходе проводимой Тель-Авивским университетом недели искусственного интеллекта, начальник Центра обработки данных и искусственного интеллекта [5] подразделения 8200 «полковник Йоав» («Colonel Yoav») прочитал согласованную с Армией обороны Израиля лекцию «Цифровая трансформация и искусственный интеллект в сфере разведки». Видео лекции, где можно услышать только голос выступающего, было размещено на YouTube-канале университета, и до недавнего времени у него было менее 100 просмотров.

В ходе своей презентации, выступающий в общих чертах рассказал об одном из используемых военной разведкой Израиля инструментов, имеющим большое сходство с ИИ-системой Lavender. Описание рабочего взаимодействия данной ИИ-системы с аналитиками разведки было весьма созвучно «модели целенаправленных операций» («model for targeting operations»), предложенной в книге командира подразделения 8200 бригадного генерала Йосси Сариэля (Yossi Sariel) [6]. Со слов «полковника Йоава», используемые подразделением 8200 инструменты искусственного интеллекта были призваны помочь преодолеть ограничения производительности труда, накладываемые человеческим фактором.

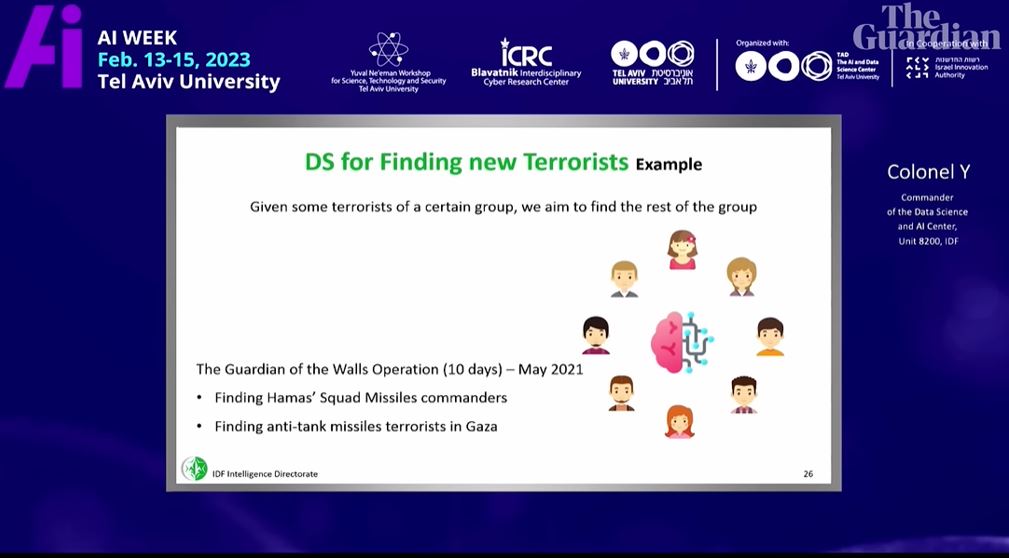

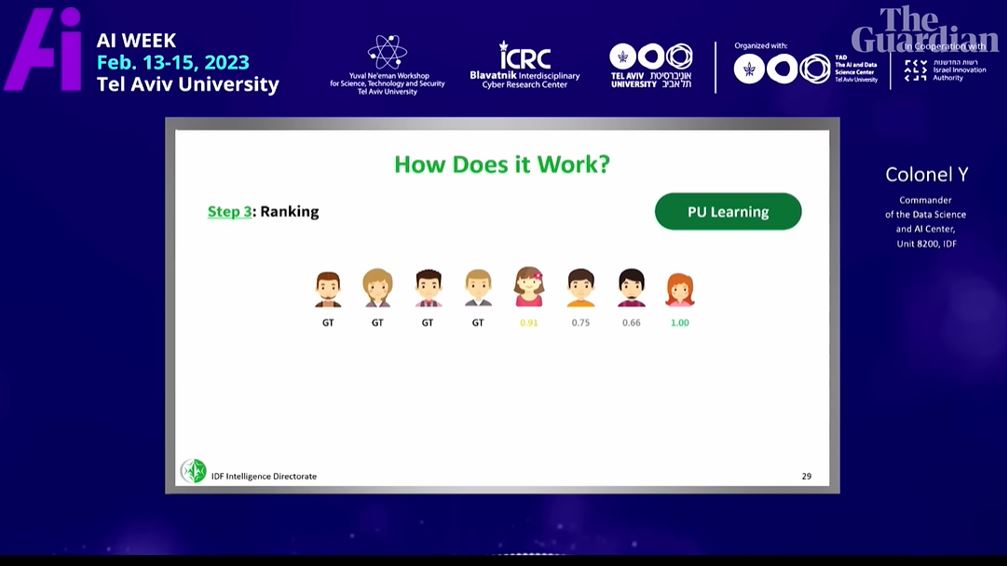

Затем в качестве практического примера применения искусственного интеллекта в разведывательной деятельности лектор рассмотрел кейс поиска командиров и операторов противотанковых комплексов ХАМАС, выполненный подразделением 8200 в ходе операции «Страж стен» в мае 2021 года. Постановка задачи звучала следующим образом — имеется некая высокопрофессиональная формализованная боевая группа, из состава которой ранее уже была установлена часть её участников. Необходимо используя технологию машинного обучения [7] (в данном случае — Positive-Unlabeled learning [8]), осуществить поиск и идентификацию остальных членов группы. В процессе решения задачи на основании исходной выборки уже известных разведке лиц устанавливается близкий круг их общения, затем оценивается релевантность выявленных связей и, наконец, проводится ранжирование полученных результатов и определение пороговых значений.

Источник: The Guardian.

Выступая за восемь месяцев до терактов 7 октября 2023 г., полковник весьма оптимистично заметил, что ЦАХАЛ переходит «из эпохи открыток в цифровую эру», где «вы во время боя можете мгновенно реагировать с помощью прикладных решений, основанных на науке о данных». Заканчивая свое выступление, полковник добавил: «Мне любопытно, как будет выглядеть следующая операция в цифровом формате».

Судя по дальнейшим событиям, спецслужбы ХАМАС сделали из полученной информации должные выводы и смогли взять под свой контроль основные информационные потоки, собираемые и обрабатываемые разведывательными органами Израиля с помощью ИИ-систем. В этих целях руководство ХАМАС отказалось от передачи оперативно значимой информации с помощью мобильных телефонов, компьютеров и иных гаджетов, но при этом придерживаясь тщательно продуманного плана дезинформации, сохранило прежний общий уровень внутренних и внешних коммуникаций. Так же, судя по всему, ХАМАС смог скрыть активность физических передвижений и тренировок боевиков, чтобы израильские алгоритмы искусственного интеллекта были уверены, что ничего странного не происходит.

Таким образом, после огласки принципов их работы, израильские ИИ-системы стали объектами состязательных атак [9] со стороны спецслужб ХАМАС, когда исторически используемые методы маскировки (камуфляжа) были дополнены специальными средствами для обмана (дезинформации) применяемой ИИ-модели.

Когда «Железные мечи» вернутся в ножны

Несмотря на то, что оперативная ситуация в секторе Газа и боевая тактика ХАМАС в течение многих лет находились под пристальным вниманием оперативников и аналитиков израильских спецслужб, ни ИИ-системы, ни оперативники и аналитики военной разведки так и не смогли выявить поведенческие аномалии, характерные для проводимой ХАМАС подготовки к началу боевых действий. В итоге в октябре 2023 г. произошел катастрофический провал израильской разведки в связи с неожиданным и весьма результативным нападением ХАМАС на Израиль.

В апреле 2024 г. из публикаций онлайн-изданий +972 и Local Call стало официально известно об использовании ЦАХАЛ упоминавшейся выше системы искусственного интеллекта — Lavender (Лаванда).

Различие между системами The Gospel и Lavender заключается в том, что если первая помечает здания и сооружения, в которых, по мнению ЦАХАЛ, могут находится выявленные и установленные цели, то вторая предназначена для выявления, маркировки и ранжирования лиц, подозреваемых в связях с военным крылом организаций ХАМАС и Исламский джихад в Палестине, в том числе и низового звена этих структур как потенциальных участников совершения терактов.

В процессе обучения алгоритмы Lavender, основываясь на наборе данных и правил в виде косвенных разведывательных признаков, характерных для профилей известных боевиков ХАМАС и Исламского джихада в Палестине, приобретали навыки поиска лиц с похожими поведенческими признаками. Закончив обучение, ИИ-система получила доступ к базам данных, включавшим в себя практически всех представителей 2,3 миллионного населения сектора Газа. После чего «натренированные» алгоритмы ИИ осуществили численную оценку вероятности того, насколько то или иное конкретное лицо может являться боевиком ХАМАС и Исламского джихада в Палестине. Объект изучения, у которого поведенческие признаки совпадали с правилами из типового профиля (паттерна) боевика, получал соответствующий индивидуальный рейтинг от 1 до 100, тем самым прогнозируя не только его принадлежность, но и возможный ранг в организации.

В качестве признаков, формировавших рейтинг подозреваемого, использовались, в частности, такие неоднозначные косвенные разведпризнаки, как его нахождение в одной группе Whatsapp с уже известным боевиком, смена мобильного телефона каждые несколько месяцев, а также частая смена адреса проживания. Многие специалисты считают, что при обучении ИИ-системы критерии отнесения к категории «боевик ХАМАС» были искусственно расширены, за счет чего высокие рейтинги соответствия получили случайные гражданские лица.

То есть Lavender, по сути дела, представляет собой специализированную рекомендательную систему «социального рейтинга», которая на базе технологий искусственного интеллекта осуществляет процесс оценки деятельности человека в режиме реального времени. Система собирает, систематизирует и анализирует огромные массивы данных о поведении всего населения Газы, принятых ими решениях и совершенных поступках с целью последующего сравнения с ИИ-моделью определенной поведенческой модели и дальнейшего ранжирования согласно степени совпадения с ней.

А теперь давайте поговорим об ограничениях и ошибках в практическом применении ИИ-систем в условиях боевых действий, которые имеют двойную природу — субъективную и объективную.

После 7 октября 2023 г. Lavender стала играть главную роль в планировании авиационных ударов по Газе, так как в рамках проведения операции «Железные мечи», было принято весьма субъективное политическое решение о распространении статуса «цели» на всех членов военного крыла ХАМАС в независимости от их ранга в организации. Все это как минимум на два порядка расширило перечень потенциальных целей для авиаударов и окончательно сделало невозможным обработку целей традиционными человеческими методами.

Причем участие человека было сведено к минимуму не только в процессе идентификации цели, но и в контрольной функции подтверждения выбранных ИИ-системой целей. Отобранные цели стали получать санкцию на удар по их уничтожению без дополнительной оценки аналитиком разведки результатов работы алгоритмов искусственного интеллекта, без изучения и верификации исходных разведывательных данных, на которых эти логические выводы были построены, и без ранее необходимого согласования сотрудника военно-юридической службы.

Нанесение ударов при заведомо возможных ошибках в идентификации целей

Точность ИИ-модели напрямую зависит от качества данных, используемых для ее обучения [10]. Современные глубокие нейронные сети во время обучения могут оптимизировать миллиарды параметров, но в данном случае ИИ-модель вряд ли содержала более нескольких сотен параметров с весьма неоднозначной интерпретацией их аннотации.

Для эффективного обучения и валидации ИИ-модели необходимы высококачественные наборы данных и отдельный независимый набор данных для её тестирования. А вот с этим уже изначально были большие объективные проблемы.

Разрешение на автоматическое включение Lavender людей в список целей на ликвидацию, ранее использовавшееся только в качестве вспомогательного инструмента, было получено после того, как сотрудники разведки «вручную» проверили точность случайной выборки из нескольких сотен целей, выбранных ИИ-системой. Когда выборка показала, что результаты Lavender достигли 90% точности в определении принадлежности человека к ХАМАС, было санкционировано её широкомасштабное применение. С этого момента, если система решала, что, то или иное лицо — боевик ХАМАС, то он без дополнительной проверки включался в «расстрельный список». А как только кто-то из включенных с список оказывался дома, то он сразу становился целью для авиаудара.

В подразделении 8200 официально признавали десятипроцентную вероятность ошибки в работе алгоритмов Lavender, помечавших в качестве приоритетных целей лиц, имевших весьма условные связи с боевиками или вообще не имевших таких связей. Так, в качестве боевиков и их связей система ошибочно маркировала лиц, которые по долгу службы (сотрудники полиции и гражданской обороны) общались с известными членами ХАМАС или Исламского джихада в Палестине или же находились с ними в родственных отношениях. То же самое относилось и к лицам, чьи установочные данные частично совпадали с именем и псевдонимом (прозвищем) установленного члена ХАМАС. Под раздачу также попадали жители сектора Газа, ранее состоявшие в ХАМАС или по той или иной причине использовавших гаджеты (подаренные, переданные или найденные), когда-то принадлежавшие его членам. Построение ИИ-модели на основе формального подхода к формированию коммуникационных профилей абонента, применяемая ко всему населению Газы в целом, значительно увеличило процент погрешности при отнесении Lavender гражданских лиц к числу боевиков. Весьма частой была ситуация, когда «цель» по какой-то причине передавала свой телефон сыну, старшему брату или просто случайному человеку. В этом случае в результате атаки в своем доме вместе со своей семьей погибал совсем другой человек.

Нанесение ударов по таким «мусорным целям», было ненамного этичнее, чем бомбардировки высотных зданий в целях «сдерживания». По сути, это были «разрушения только для того, чтобы вызвать разрушения».

Ошибки некритичного отношения пользователей ИИ-системы к результатам её работы довольно распространенная мировая практика. Так, в начале апреля 2024 г. Генеральная прокуратура России официально извинилась перед российским ученым за ложное обвинение в массовых убийствах. В начале 2023 г. гидролога Александра Цветкова обвинили в совершении серии убийств 20-летней давности. Система распознавания лиц на основе искусственного интеллекта в аэропорту Домодедово посчитала, что составленный в 2003 г. фоторобот убийцы на 55% совпадает с изображением Цветкова. В итоге мужчина был задержан и до февраля 2024 г. находился в следственном изоляторе. Но самое интересное, что у Цветкова на те дни, когда в Москве произошли убийства было железное алиби. Он в окружении коллег находился в отдаленном труднодоступном районе Костромской области, за много километров от столицы.

Опасные последствия применения технологий ИИ в военных целях

Ранее в израильской армии термин «цель» или «живая мишень» относился только к высокопоставленному члену военного крыла ХАМАС, который, согласно правилам отдела международного права ЦАХАЛ, мог быть убит в своем частном доме, даже если вокруг него находились гражданские лица. Поэтому во время предыдущих палестино-израильских конфликтов во имя сохранения принципа пропорциональности и в соответствии с международным правом, гибель вместе с целью его семьи допускалась довольно редко. Подобные цели отбирались очень тщательно, и только высшее военное руководство ХАМАС подвергались бомбардировкам в своих домах. Поэтому процесс выбора целей для ударов ВВС был весьма трудоемким мероприятием. К тому же окончательное решение о внесение человека в список высокопоставленных боевиков и тем более идентификация его как законной цели подлежало детальному обсуждению, и затем подтверждалось юридическим заключением.

После 7 октября 2023 г. де-факто перед нанесением авиаудара дежурный оператор стал проводить лишь 20 секундную проверку того, что объект, помеченный ИИ-системой в качестве цели — мужчина. Логика этих действий исходила из того, что выбор в качестве «цели» женщины, однозначно говорил об ошибке идентификации, так как в рядах боевиков ХАМАС и Исламского джихада в Палестине женщины отсутствовали.

Нанесение ударов по гражданским объектам

Еще один серьезный субъективный фактор морально-этического характера в использовании ИИ-систем связан со способом нанесения «ударов возмездия». Основные авиаудары по боевикам израильская армия наносила вовсе не в ходе боевых действий, ведущихся в плотной городской застройке, так как они, с точки зрения военных, были малоэффективны. Охота на маркированные цели обычно начиналась в ночное время суток, когда потенциальные «люди-мишени» возвращались в свои жилые дома, где находились в кругу своей семьи.

Да, действительно имеются свидетельства того, что разветвленная система туннелей ХАМАС намеренно проходит под больницами и школами, для передвижения по которым боевики часто используют машины скорой помощи, а также то, что военные объекты ХАМАС расположены рядом с гражданскими зданиями. Однако, по мнению ряда источников СМИ, в отличие от официальных заявлений израильской армии, основной причиной беспрецедентного числа жертв нынешних израильских бомбардировок является то, что удары по намеченным системой целям наносятся при их нахождении дома, в кругу семьи. Отчасти это происходит потому, что, с точки зрения аналитиков подразделения 8200, разметка с помощью ИИ-систем жилых домов происходит с меньшей затратой людских и временных ресурсов.

С учетом насыщенности сектора Газа армейскими системами видеонаблюдения, там имеется реальная возможность автоматической привязки его жителей к местам их проживания. Для того, чтобы в режиме реального времени идентифицировать момент, когда члены ХАМАС возвращаются в свои дома, были разработаны различные дополнительные программные модули. Они позволяют одновременно отслеживать тысячи объектов оперативного интереса, и определять, когда они возвращаются домой, отправляя автоматическое оповещение оператору, который затем помечает дом для бомбардировки. Один из таких программных модулей называется «Where's Daddy?» («Где папа?»).

В результате ЦАХАЛ, особенно в первые недели конфликта, не колеблясь наносил ракетно-бомбовые удары по жилым домам, что приводило к гибели тысячи палестинцев, большинство из которых составляли мирные жители, не участвовавшие в боевых действиях, в первую очередь — женщины и дети.

Нанесение ударов по целям с помощью дешевых неуправляемых боеприпасов

Еще одним субъективным фактором, обеспечившим высокое количество жертв среди мирного населения, было то, что при нанесении ударов по размеченным Lavender предполагаемым боевикам низшего звена, израильская армия в целях экономии предпочитала использовать только неуправляемые бомбы и ракеты. В отличие от высокоточных «умных» бомб, эти боеприпасы разрушали жилые здания целиком, что в итоге приводило к высоким жертвам среди мирного населения.

В декабре 2023 г. телеканал CNN сообщил, что, согласно оценке, составленной Управлением директора Национальной разведки США из 29 тыс. боеприпасов класса «воздух-земля», использованных израильскими ВВС в Газе, порядка 45% были неуправляемыми, а значит наносящими больший сопутствующий ущерб, чем современное «умное» оружие. В ответ на это представитель армии Израиля пространно заявил: «Как военные, приверженные международному праву и моральному кодексу поведения, мы выделяем огромные ресурсы на то, чтобы свести к минимуму ущерб гражданским лицам, которых ХАМАС заставил играть роль живого щита. Наша война ведется против ХАМАС, а не против народа Газы». В то же время источники +972 и Local Call в израильской разведке утверждали, что в целях экономии более дорогого «умного» оружия по целям из состава низшего звена боевиков удары наносились только с помощью неуправляемых боеприпасов.

Со слов одного из источников, ВВС не наносили удар по цели невысокого ранга, если она жила в высотном здании, так как для этого нужно было бы применить более точную и дорогую «напольную бомбу» (с более ограниченным побочным эффектом). Но если данная цель находилась в малоэтажном здании, то не было ограничений на удар с помощью неуправляемой бомбы, который мог уничтожить всех находившихся в здании.

Использование неуправляемых боеприпасов в сочетании с методами идентификации целей при помощи искусственного интеллекта, привело к значительному росту числа жертв среди гражданского населения Газы. Даже президент Джо Байден несмотря на то, что США продолжало отправлять Израилю оружие, предупредил руководство Израиля, что страна может потерять международную поддержку из-за «не избирательных бомбардировок» сектора Газа.

Санкционирование нанесения ударов с возможностью жертв среди гражданского населения

По словам источников онлайн-изданий +972 и Local Call, в первые недели конфликта руководство ЦАХАЛ приняло политическое решение о том, что при ликвидации рядового состава боевиков ХАМАС в качестве «сопутствующего ущерба» допустима гибель до 15–20 мирных жителей. Это число не было постоянным оно с течением времени то увеличивалось, то уменьшалось.

Ранее израильские военные при подобных акциях против боевиков низкого ранга не давали санкций на столь серьезный «сопутствующий ущерб» среди мирных жителей. В случае, если же целью удара становился высокопоставленный член ХАМАС в ранге от командира батальона и выше, руководство ЦАХАЛ давало «добро» на возможную гибель в ходе нанесения удара более 100 мирных жителей.

В первую неделю после 7 октября атаки шли практически без учета сопутствующего ущерба, и никто не контролировал общее количество людей, погибших в каждом разбомбленном доме. Через неделю после начала конфликта были введены первые ограничения на сопутствующий ущерб, он сократился с 15 до 5 человек, что значительно затруднило нанесение ударов, так как теперь если вся семья находилась дома, то атака не могла быть проведена. Затем число возможных жертв при сопутствующем ущербе было снова повышено.

Эти степени сопутствующего ущерба применялись ко всем подозреваемым в причастности к ХАМАС независимо от их ранга, военной значимости, возраста и без какой-либо конкретной экспертизы в каждом конкретном случае, чтобы взвесить военную выгоду от их убийства с ожидаемым ущербом для гражданского населения.

На практике принципа пропорциональности не существовало, армейский департамент международного права никогда прежде не давал такого широкого одобрения на столь высокий уровень сопутствующего ущерба. Каждый человек, который сотрудничал с ХАМАС в последние год-два, мог быть подвергнут бомбардировке со значительным сопутствующим ущербом. Такая заранее определенная и фиксированная степень потерь среди гражданского населения давала возможность с помощью Lavender значительно ускорить массовую идентификацию целей на поражение.

Затем, отчасти из-за американского давления, израильская армия перестала создавать массовые цели для бомбардировок домов мирных жителей. К тому же, к этому времени большинство домов в секторе Газа уже было разрушено или повреждено, а почти все население было перемещено. Все это сделало сведения из разведывательных баз данных и автоматизированных программ определения местоположения домов мало релевантными.

Массированные удары по низовому звену боевиков, имевшие место в первые две недели конфликта, в дальнейшем были прекращены в основном из-за экономической причины — перерасхода боеприпасов. Однако авиаудары по высокопоставленным командирам ХАМАС были продолжены. Причем при таких атаках цифра сопутствующего ущерба могла достигать «сотен» гражданских лиц на каждую пораженную цель. Все это официальная политика ЦАХАЛ, для которой нет исторических прецедентов ни в Израиле, ни в США.

Так, во время удара по командиру батальона «Шуджайя» Виссаму Фархате (Wissam Farhat) операторы ИИ-системы прекрасно понимали, что потери среди мирных жителей составят более 100 человек. По данным правозащитной группы «Бецелем», бомбардировка в тот день разрушила десятки зданий, убила десятки людей и еще сотни похоронила под руинами их домов.

Для того, чтобы ликвидировать командира бригады ХАМАС в Центральной Газе Аймана Нофаля, в результате авиаударов по лагерю беженцев Аль-Буридж было разрушено от 16 до 18 крупных многоэтажных жилых домов. Только в первый день из-под завалов зданий извлекли около 50 погибших и 200 раненых, многие из которых были тяжелыми. На эвакуацию всех убитых и раненых понадобилось около пяти дней. В результате бомбардировки 20 декабря 2023 г. был разрушен «целый жилой квартал» и погибли по меньшей мере 10 детей.

Часто высокопоставленные командиры ХАМАС и Исламского джихада в Палестине скрывались в подземных коммуникациях, которые проходили под жилыми и общественными зданиями, поэтому авиаудары по тоннелям также приводили к гибели гражданского населения. Но ради ликвидации командиров ХАМАС и Исламского джихада в Палестине израильтяне с легкостью шли на жертвы среди мирных жителей. Причем подобный уровень сопутствующего ущерба являлся исключительным не только по сравнению с тем, что израильская армия ранее считала приемлемым, но и по сравнению с теми войнами, которые вели Соединенные Штаты в Ираке, Сирии и Афганистане.

Заместитель командующего по операциям и разведке в операции по борьбе с ИГИЛ в Ираке и Сирии генерал Питер Герстен (Peter Gersten) в 2021 г. заявил американскому журналу, что атака, в результате которой пострадали 15 мирных жителей, не соответствовала процедуре. Для ее осуществления он должен был получить специальное разрешение от главы Центрального командования США генерала Ллойда Остина (Lloyd James Austin). По словам Герстена, в случае с Усамой бен Ладеном у вас был бы показатель потерь среди некомбатантов (Non-combatant casualty value, NCV) [11] 30, но если бы у вас был командир низкого уровня, его NCV обычно был бы равен нулю».

Нападение ХАМАС стало шоком для населения Израиля из-за его внезапности, масштаба и полной неготовности властей. В считанные часы, палестинцы устроили в Израиле жуткий хаос, показав местным жителям, что никто не застрахован от нападения и не может в полной мере надеяться на поддержку армии и полиции.

Жесткие ответные действия кабинета Нетаньяху имели в первую очередь чисто пропагандистскую цель — отвлечь население от вопросов: почему хорошо подготовленная Армия обороны Израиля и многочисленные израильские спецслужбы оказались полностью не готовыми к нападению? Поэтому было принято политическое решение, что каждая цель, связанная с ХАМАС вне зависимости от сопутствующего ущерба — законная. Никто не думал о том, что будет после того, как закончится война. Ведь в долгосрочной перспективе всё это приведет только к еще большему усилению конфронтации, так как у родственников и друзей погибших в Газе будет серьезная мотивация к поддержке ХАМАС.

Нанесение ударов по целям на основании моделей, слабо связанных с реальностью при весьма слабой оценке сопутствующего ущерба

Процедура подсчета возможных потерь среди гражданского населения при нанесении авиаударов проводилась в автоматическом режиме при помощи весьма неточных инструментов. Если во время предыдущих военных конфликтов сотрудники разведки в живую проверяли сколько людей может находиться в доме, который должен был быть уничтожен, и даже указывали количество мирных жителей, которые могли погибнуть при ударе в специальной части досье цели, то после 7 октября от тщательной проверки первичной развединформации отказались в пользу весьма приблизительных автоматизированных расчетов.

В октябре 2023 г. The New York Times сообщила об ИИ-системе, собирающей информацию о количестве мобильных устройств, работающих в секторе Газа, и на основании этих данных, предоставляющей ЦАХАЛ оперативную оценку числа палестинцев, переместившихся из северной части сектора Газа на юг. Бригадный генерал Уди Бен Муха в своем интервью данной газете открыто признал: «Это не 100% совершенная система, но она дает вам информацию, необходимую для того, чтобы принять решение». Система подсвечивала районы сектора Газа в соответствии с информацией о количестве людей: красным цветом отмечались районы с высокой концентрацией жителей, а зеленым и желтым — районы, которые в значительной степени жители покинули.

Аналогичным образом шёл расчет сопутствующего ущерба, использовавшийся для принятия решения о бомбардировке того или иного здания в Газе. Если данные биллинга показывали, что количество используемых мобильных устройств сократилось вдвое, то программа автоматически наполовину сокращала возможное количество жильцов во всех домах района, что было весьма спорным. К тому же в целях экономии времени, в отличии от предыдущих операций, никто для контроля точности программы оценки в реальном времени не проверял, сколько в настоящее время людей на самом деле там находится.

В армии Израиля прекрасно понимали, что в оценках возможного сопутствующего ущерба наличествуют серьезные системные ошибки, но все равно применяли эту весьма спорную модель, из-за удобства её использования. В результате расчет сопутствующего ущерба был полностью основан на усредненной статистике, а его цифры даже не были целыми числами.

Нанесение ударов по целям без предварительной проверки исходной информации

На пути к искусственному интеллекту — пришествие демона Лапласа

Часто при передаче данных о цели в ВВС имел место существенный временной лаг между моментом, когда система «Where's Daddy?» информировала оператора о том, что цель вернулась в свой дом, и временем нанесения удара. Поскольку проверка разведданных в режиме реального времени не проводилась, это приводило к неоднократным случаям нанесения ударов по домам-целям, когда «человека-мишени» во время атаки внутри дома не было.

К примеру, цель была зафиксирована у себя дома в 8 часов вечера. Авиация нанесла удар в 3 часа ночи. Впоследствии было установлено, что цель успела переехать со своей семьей в другой дом. В результате в уничтоженном доме погибли две семьи с детьми.

Во время предыдущих конфликтов в Газе после проведенной акции израильская разведка в обязательном порядке осуществляла так называемую процедуру BDA [12] — проверку результатов удара с оценкой сопутствующего ущерба, чтобы подтвердить факт гибели объекта атаки и оценить количество жертв среди мирного населения. Как правило BDA осуществлялось посредством прослушивания телефонных переговоров родственников погибших. Однако в текущей ситуации, по крайней мере в отношении ударов по лицам из низового звена боевиков, эта процедура была отменена в целях экономии времени. Причем проверка не проводилась не только в отношении оценки жертв среди мирных жителей, но и в отношении результата поражения самого объекта удара.

Процедуре BDA израильтяне следовали только в том случае, если речь шла о высокопоставленных боевиках ХАМАС. В остальных случаях достаточно было доклада ВВС об уничтожении здания. Упор был сделан только на том, чтобы как можно быстрее поразить наибольшее количество целей.

В результате, полагаясь на алгоритмы Lavender, армия Израиля нанесла удары (в том числе и по жилым домам) в отношении 37 тыс. палестинцев, подозреваемых в принадлежности к боевикам ХАМАС. Итоги этой деятельности известны — ХАМАС так и не потерял боеспособности, военная операция не достигла ожидаемого успеха, зато жертвами конфликта в секторе Газа стали 33 545 мирных палестинцев, а 76 094 человека получили ранения.

Выводы

У системы искусственного интеллекта в отличие от человека нет совести, нет сожаления и ужаса от содеянного. У ИИ нет души, есть только алгоритм и конечный результат, который надо получить любым способом. ИИ-системе глубоко все равно, что в отсутствие конечного результата, количество жертв «сопутствующего ущерба» запредельно.

Использование алгоритмов искусственного интеллекта в разведывательной деятельности оправдано ровно настолько, насколько достоверны и прозрачны для проверки исходные данные и алгоритмы, используемые для их обработки. Но если аналитики разведки и разработчики ИИ вовремя не выявили рубежные ограничения технологии или допустили внесение в алгоритм изначально ошибочных аналитических методологий, то те же самые проблемы возникнут в последствии и у разведывательного продукта, создаваемого с помощью искусственного интеллекта.

1. ВВС — Военно-воздушные силы Армии обороны Израиля.

2. Подразделение 8200 (ивр. יחידה 8200) — израильское подразделение радиоэлектронной разведки, входящее в Управление военной разведки («АМАН») Армии обороны Израиля.

3. Модели искусственного интеллекта/машинного обучения (ИИ-модели) — это математические алгоритмы, которые с помощью вклада человека (эксперта) «обучаются» на наборах данных воспроизводить решение, которое эксперт примет при анализе такого же набора данных. Обучившись воспроизводить решение эксперта, модель в дальнейшем функционирует самостоятельно, позволяя таким образом автоматизировать решение задач.

4. Экс-разведчик Риттер назвал увлечение Израиля ИИ причиной атак ХАМАС // Известия. 09.10.2023. URL: https://iz.ru/1586341/2023-10-09/eks-razvedchik-ritter-nazval-uvlechenie-izrailia-ii-prichinoi-atak-khamas ; Davies, H. “The Gospel“: how Israel uses AI to select bombing targets in Gaza // The Guardian. 01.12.2023. URL: https://www.theguardian.com/world/2023/dec/01/the-gospel-how-israel-uses-ai-to-select-bombing-targets

5. В своей презентации полковник уточнил, что структура, которой он руководит в подразделении 8200, также известна как «Центр интеграции человека и машины».

6. В 2021 году на английском языке под псевдонимом «бригадный генерал Ю.С.» вышла монография «Человеко-машинная команда» («The Human Machine Team»). В данном материале рассматривались возможности создания технологии скоростной обработки больших информационных массивов в целях выявления потенциальных объектов (целей, мишеней) нанесения ракетно-бомбовых ударов. Такая технология, по мнению автора, должна была устранить человека как узкое место как из этапа определения местоположения новых целей, так и из процесса принятия решения об их утверждении.

7. Машинное обучение — это класс методов для решения задач искусственного интеллекта. Алгоритмы машинного обучения распознают паттерны в больших массивах данных и используют их для самообучения. Каждый новый массив данных позволяет алгоритмам совершенствоваться и адаптироваться в соответствии с полученной информацией, что позволяет постоянно улучшать точность рекомендаций и прогнозов.

8. Позитивное неразмеченное обучение (Positive-Unlabeled learning) — обучение на основе положительных неразмеченных данных. PU learning — аналог бинарной классификации для случаев, когда имеются размеченные данные только одного из классов (установленные ранее боевики), но доступна неразмеченная смесь данных обоих классов (связи боевиков, содержащие как их коллег, так и случайных гражданских лиц). В общем случае не известно, сколько данных в смеси соответствует положительному классу, а сколько — отрицательному. На основе таких наборов данных необходимо построить бинарный классификатор, такой же, как и при наличии чистых данных обоих классов. Размеченные данные — это данные, дополненные метками/классами, содержащими значимую информацию.

9. Состязательные атаки — специальная модификация входных данных для предотвращения корректной работы систем искусственного интеллекта или наоборот — достижения желаемой работы.

10. Данными обучения называются данные, применяемые для тренировки алгоритма машинного обучения.

11. Non-combatant casualty value (NCV) и Non-combatant and civilian casualty cut-off value (NCV or NCCV) — показатель потерь среди некомбатантов (NCV), также известный как предельный показатель потерь среди некомбатантов и гражданского населения (NCV или NCCCV).

12. Оценка ущерба от бомб (Bomb damage assessment, BDA), также известная как оценка боевого урона, представляет собой практику оценки ущерба, нанесенного цели бомбой или ракетой воздушного базирования.

(Голосов: 17, Рейтинг: 4.53) |

(17 голосов) |

Аналитическая записка №41 / 2023

Опасные последствия применения технологий ИИ в военных целяхТакие программные инструменты, как Palantir AI, Primer AI и Clearview AI, которые применяются в рамках вооруженного конфликта на территории Украины, демонстрируют трансформацию методов ведения боевых действий

На пути к искусственному интеллекту — пришествие демона ЛапласаПродолжающаяся гонка разведок во все большей степени превращается из поединка разведчиков и контрразведчиков в битву искусственных интеллектов

«Цифровой шторм» Аль-Акса: штрихи к противостоянию Израиля и ХАМАСФормирование «постоянной напряженности» в киберпространстве может стать ответом ХАМАС на успехи ЦАХАЛ в секторе Газа

Когда «Железные мечи» вернутся в ножныМожет быть, представление о том, что устоявшаяся парадигма «двух государств» не имеет работающих альтернатив, нуждается в уточнении или даже в переосмыслении?