За два года, прошедшие с прошлого обзора технологий искусственного интеллекта, произошло дальнейшее увеличение разрыва между кажущимся всемогуществом нейросетевых моделей, основанных на «глубоком обучении», предлагаемых лидерами рынка, и требованиями «алгоритмической прозрачности», предъявляемыми обществом. В новом обзоре мы попробуем детально исследовать этот разрыв и обсудим тренды и решения, способные как привести к разрешению данной проблемы или же её дальнейшему усугублению.

Ключевые проблемы: проблема сознания, мультимодальность, сверхглубокое обучение, базисные модели, алгоритмическая непрозрачность, тоталитаризация использования, энерго-(не)эффективность, милитаризация.

Зоны роста: исследование «глубины» искусственного интеллекта, сопоставление моделей параметров и синапсов, переход от объяснимости к интерпретируемости, формализация подходов к этичности ИИ.

В гуманитарной перспективе необходимым представляется активизировать взаимодействие государств — ведущих участников «гонки за ИИ» и гонки вооружений (России, США и Китая) в рамках ООН с целью достижения полного запрета на разработку, развертывание и применение автономных систем смертоносных вооружений (LAWS).

В свою очередь, разработчикам систем универсального общего ИИ при выходе на международные рынки придется предусматривать возможность преконфигурации своих систем принятия решений на основе ИИ с учетом этических норм и культурных укладов целевых рынков, что может быть сделано, например, встраиванием «базовых ценностей» с учетом особенностей целевого рынка, на основе фундаментального слоя «графа знаний», при реализации систем на основе «интерпретируемого ИИ».

При этом, никакое мировое лидерство невозможно при существующем уровне отставания в области разработки и развертывания «сверхглубоких» нейросетевых моделей. Этот отрыв России от лидеров (США и Китая) необходимо сокращать на основе как собственных программных разработок, так и собственного вычислительного оборудования, так и собственных данных для тренировки этих моделей.

Однако с учетом принципиальных проблем, ограничений и возможностей, представляет интерес потенциал прорыва как раз в области интерпретируемого ИИ и гибридных нейросимвольных архитектур, где пока сохраняется лидерство российской математической школы, что, в частности, было подтверждено призом за лучшую когнитивную архитектуру, которым была удостоена группа новосибирских разработчиков на международной конференции по общему искусственному интеллекту AGI-2020. При том, что с точки зрения практической применимости данное направление сейчас находится сейчас примерно в том же состоянии, в каком глубокие нейросетевые модели находились 10–15 лет назад, промедление в его практическим развитии может привести к стратегическому отставанию и в этой области.

За два года, прошедшие с прошлого обзора технологий искусственного интеллекта, произошло дальнейшее увеличение разрыва между кажущимся всемогуществом нейросетевых моделей, основанных на «глубоком обучении», предлагаемых лидерами рынка, и требованиями «алгоритмической прозрачности», предъявляемыми обществом. В новом обзоре мы попробуем детально исследовать этот разрыв и обсудим тренды и решения, способные как привести к разрешению данной проблемы или же её дальнейшему усугублению.

1. Итоги последних лет

Прежде всего, повестка так называемого «сильного» или «общего» ИИ (СИИ или ОИИ —Artificial General Intelligence или AGI) стала общепризнанной во всем мире. На русском языке вышла посвященная этой теме книга, написанная коллективом русскоязычных исследователей и разработчиков, где возможные направления развития данной технологии разобраны тщательным образом. Последние два года еженедельно проходят открытые семинары русскоязычного сообщества разработчиков сильного ИИ.

Сознание. Одной из ключевых проблем, связанных с созданием или возникновением СИИ/ОИИ, является проблема сознания, обозначенная в раннем нашем обзоре. Предметом дебатов стала как сама возможность его возникновения у искусственно созданных систем, так и то, насколько целесообразно для человечества наделять такие системы сознанием в случае, если это в принципе возможно. Как сформулировал П.К.Анохин на конференции OpenTalks.AI в 2018 г., «мы должны изучать проблему сознания, чтобы не допустить его возникновения у ИИ». Примечательно, что одним из первейших условий возникновения сознания у искусственных систем, согласно материалам круглого стола на семинаре AGIRussia в 2020 г., была определена возможность систем ИИ осуществлять так называемое «мультимодальное» поведение, с возможностью интеграции информации из различных сенсорных модальностей (например, текст, изображение, видео, звук, и т.д.), осуществляя «привязку» («grounding») информации разных модальностей окружающей реальности с построением полноценных связных «образов мира», как это присуще человеку.

Мультимодальность. Как раз в последней области в 2021 году произошло сразу несколько технологических прорывов, обещающих дальнейшее развитие в этом направлении. Например, система DALL-e проекта OpenAI получила возможность генерировать изображения по текстовым описаниям сцен, будучи натренированной на мультимодальных данных, включающих тексты и изображения, а система Codex, как было продемонстрировано тем же проектом OpenAI, получила возможность генерировать программный код по текстовым спецификациям алгоритмов.

Сверхглубокое обучение. В продолжившейся гонке за «глубину» нейросетевых моделей, где долгое время соревновались американские компании Google, Microsoft (совместно с OpenAI) и Amazon, в борьбу за пальму первенства вступили китайские Baidu, Tencent и Alibaba. В ноябре 2021 г. Alibaba создала рекордную на сегодняшний по числу параметров мультимодальную сеть M6. Число параметров или связей в последней достигает 10 трлн, что всего на один порядок меньше числа синапсов в человеческом мозге, по последним данным.

Базисные модели. Сверхглубокие мультимодальные нейросетевые модели уже получили определение «базисных моделей» — их потенциальным возможностям и связанным с этим угрозам посвящен развернутый аналитический отчет, подготовленный Стэнфордским университетом силами ведущих мировых специалистов в области ИИ. Дальнейшее развитие этих моделей, с одной стороны, может рассматриваться как ближайшая перспектива движения в сторону СИИ/ОИИ, с повышением интеллектуальных способностей системы за счет дальнейшего наращивания числа параметров (с превышением их числа в мозге человека), воспринимаемых модальностей (включая новые модальности, недоступные человеческому организму), а также используемых для обучения гигантских объемов данных (физически недоступных отдельному человеку). Последнее позволяет некоторым исследователям говорить о создании на основе таких систем «сверхчеловеческого ИИ» на горизонте нескольких лет. Однако в связи с этим остается ряд серьезных вопросов, связанных с проблемой сознания, непрозрачности, милитаризацией использования и др.

Алгоритмическая (не)прозрачность. Дальнейшее «углубление» глубоких моделей только обостряет противоречие с требованиями упомянутой выше «алгоритмической прозрачности», все более настоятельно предъявляемыми к системам принятия решений на основе ИИ по мере их распространения. В различных странах принимаются и обсуждаются ограничения на применимость «непрозрачного» ИИ в областях, связанных с безопасностью, правами, жизнью и здоровьем граждан. Примечательно, что такие ограничения могут серьезно затруднить применимость ИИ как раз в ситуации, когда он мог бы помочь, в условиях продолжающейся пандемии COVID-19, облегчить решение проблемы массовой диагностики при лавинообразном росте числа обследований и катастрофической нехватке медицинских кадров необходимой квалификации.

Тоталитаризация использования. Применимость алгоритмов и приложений ИИ становится повсеместной, охватывающий всех и каждого во всех аспектах повседневной деятельности, включая любые перемещения, финансовую, потребительскую, культурную и социальную активности. При этом, контролерами и бенефициарами его массового применения оказываются, прежде всего, глобальные корпорации и контролирующие их государства. Как мы уже писали ранее, активное население Земли поделено на неравные сферы влияния американских (Google, Facebook, Microsoft, Apple, Amazon) и китайских (Baidu, Tencent, Alibaba) корпораций. Усиление возможных манипуляций со стороны этих корпораций и государств, ориентированных на максимизацию прибылей мажоритарных акционеров и сохранение власти правящих элит, с ростом мощности находящихся у них в распоряжении ИИ-систем объективно может только возрастать. Симптоматично, что анонсированный изначально как открытый, ориентированный на службу обществу, проект OpenAI закрыл свой код и становится все более финансово зависим от Microsoft.

Энерго-(не)эффективность. В то время, как «модная» технология «майнинга» криптовалют уже давно вызывает все больше критики в силу своей неэкологичности, энергопотребление систем «сверхглубокого» обучения и связанный с этим углеродный след также становится предметом беспокойства. В частности, в публикациях последних результатов мультимодальной системы OpenAI Codex, созданной совместно с Microsoft, тема воздействия данной технологии на окружающую среду обсуждается в отдельном разделе. При том, что существующее число параметров в крупнейших нейросетевых моделях на несколько порядков меньше числа синапсов в человеческом мозге, рост числа таких моделей и параметров в них будет вести к экспоненциальному росту негативного воздействия таких систем на окружающую среду. Эффективность человеческого мозга, потребляющего неизмеримо меньшее количество энергии на то же самое число параметров, для существующих вычислительных архитектур пока остается недостижимой.

Милитаризация. На фоне отсутствия каких-либо значимых подвижек по запрету на создание автономных систем смертоносных вооружений (Lethal Autonomous Weapons Systems, LAWS) на международном уровне, такие системы уже начинают применяться спецслужбами. Тот факт, что успешное использование ударных беспилотников уже становится решающим фактором в локальных военных конфликтах, более широкое применение автономных систем на действующих и будущих театрах военных действий может оказаться делом самого недалекого будущего, с учетом того, что живые пилоты уже не в состоянии противостоять системам ИИ в симуляции реальных воздушных боёв. Невозможность объяснить и предугадать поведение таких систем при их распространении и возможном выходе в космос не требует комментариев. К сожалению, обострение стратегической конкуренции между мировыми лидерами как «в гонке за ИИ» так и в гонке вооружений пока оставляет мало надежд на достижение консенсуса в условиях конкуренции, как было указано в нашем прошлом обзоре еще в 2020 г.

2. Перспективы развития

В свете сказанного выше можно кратко обсудить возможные «зоны роста», включая те, где дальнейшее развитие критически необходимо.

Что скрывается за «глубиной»? Как показывают экспертные обсуждения, например, прошедший в сентябре 2021 г. семинар с участием ведущих вычислительных лингвистов Sberbank и Google, цитируя одного из участников, — «никакого интеллекта там нет». По сути, самые глубокие нейросетевые модели являются высокопроизводительными и высокозатратными устройствами ассоциативной памяти, хотя и работающие на скоростях и объемах информации, уже превышающими человеческие возможности в большом числе прикладных задач. Однако сами по себе они не в состоянии адаптироваться к новым условиям среды, если они не настроены на неё вручную и не способны формировать новые знания в виде выделяемых в среде явлений и связывающих их причинно-следственных моделей мира, и тем более — делиться этими знаниями с другими субъектами среды, будь то люди или другие подобные системы.

Сводятся ли параметры к синапсам? Традиционно, сопоставление мощностей «глубоких» нейросетевых моделей с ресурсами человеческого мозга осуществляется на основе числа параметров нейросети в предположении, что каждый параметр соответствует отдельному синапсу между биологическими нейронами в классической графовой модели коннектома мозга человека, воспроизводимой нейросетями со дня изобретения перцептрона более 60 лет назад. Однако это ни в коей мере не учитывает возможность ветвлений дендритов самостоятельно обрабатывать информацию, а также гиперграфовые и метаграфовые структуры на аксонах и дендритах, возможность действия различных нейромедиаторов в одних и тех же синапсах и эффектов, связанных с интерференцией нейромедиаторов от различных аксонов в рецептивных кластерах. Недоучет хотя бы одного из названных выше факторов на десятки порядков отдаляет уровень сложности и емкости человеческого мозга от существующих «сверхглубоких» нейросетевых моделей и ставит под вопрос применимость их архитектур к задаче воспроизведения человеческого интеллекта in-silico.

От объяснимости к интерпретируемости. Хотя развитие технологий «объяснимого ИИ» позволяет «закрывать» юридические проблемы в случаях, связанных с защитой прав граждан, позволяя компаниям генерировать более или менее удовлетворительные «объяснения» в случаях, предусмотренных законодательством, в общем случае проблему нельзя считать решенной. По прежнему открытым остается вопрос «интерпретируемости» полученных в результате обучения моделей до начала их фактического применения, чтобы иметь возможность избежать ситуации, когда запоздалые «объяснения» уже не смогут вернуть человеческие жизни. В данной перспективе представляет интерес развитие гибридных нейросимвольных архитектур — «вертикальных и горизонтальных». «Вертикальная» нейросимвольная архитектура предполагает использование искусственных нейросетей на «нижних уровнях» для низкоуровневой обработки входных сигналов (например, видео и аудио) и «символьных» систем на основе вероятностной логики (Discovery, Евгений Витяев и OpenCog, Ben Goetzel) или неаксиоматической логики (NARS, Pei Wang) — для высокоуровневой обработки поведенческих схем и принятия решений.

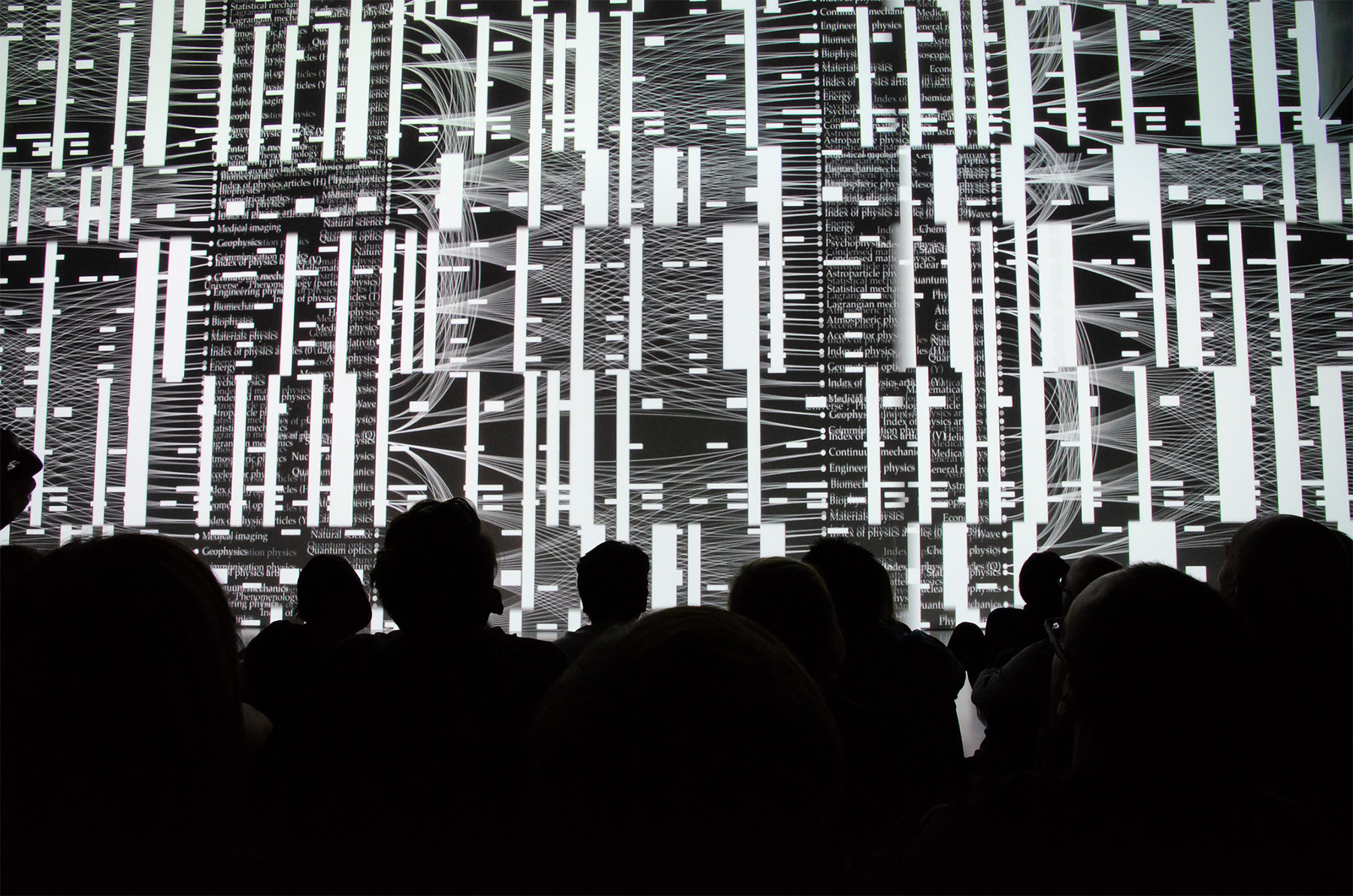

Вертикальная нейро-символьная архитектура объяснимого ИИ, источник Society of Mind (Marvin Minskey)

В свою очередь, «горизонтальная» нейросимвольная архитектура предполагает возможность представления одних и тех же знаний как в нейросети, реализующей интуитивную систему «первого типа» по Дэниелу Каннеману, так и в логической системе «второго типа», работающей на основе все той же вероятностной или неаксиоматической логики. При этом, предполагается, что «модели», неявно выученные и неявно применяемые в первой системе, могут трансформироваться в «знания», явно выводимые и анализируемые во второй, причем обе системы могут действовать независимо на состязательной основе, делясь друг с другом «опытом» в процессе непрерывного обучения.

Можно ли формализовать этичность? В то время, как вопросы этичности применимости ИИ в различных сферах все активнее обсуждаются на государственном и межгосударственном уровнях, становятся очевидны «национальные особенности» в развитии законодательств в этой части, прежде всего — США, Евросоюза, Китая, России и Индии. Исследования показывают существенные различия в интуитивном понимании этичности носителями различных национальных культур. В частности, концепция «Законов Азимова» представляется бесполезной хотя бы потому, что в критических ситуациях сами люди оказываются в ситуации, когда действием либо бездействием приходится причинить вред одним в пользу других. В случае, если системы ИИ будут далее применяться (и уже применяются на транспорте) там, где принимаемые автоматом решения будут приводить к увечьям и смерти одних в пользу других, неизбежно развитие законодательных актов применительно к таким системам с учетом этических норм национального характера, и разработчикам ИИ, работающим на международных рынках, придется адаптироваться к местным законодательствам в области этики ИИ так же, как это происходит сейчас с системами обработки персональных данных, вынужденным адаптироваться к местным законам каждой отдельной стране.

3. Следующие шаги

Итак, в гуманитарной перспективе необходимым представляется активизировать взаимодействие государств — ведущих участников «гонки за ИИ» и гонки вооружений (России, США и Китая) в рамках ООН с целью достижения полного запрета на разработку, развертывание и применение автономных систем смертоносных вооружений (LAWS).

В свою очередь, разработчикам систем универсального общего ИИ при выходе на международные рынки придется предусматривать возможность преконфигурации своих систем принятия решений на основе ИИ с учетом этических норм и культурных укладов целевых рынков, что может быть сделано, например, встраиванием «базовых ценностей» с учетом особенностей целевого рынка, на основе фундаментального слоя «графа знаний», при реализации систем на основе «интерпретируемого ИИ».

При этом, никакое мировое лидерство невозможно при существующем уровне отставания в области разработки и развертывания «сверхглубоких» нейросетевых моделей. Этот отрыв России от лидеров (США и Китая) необходимо сокращать на основе как собственных программных разработок, так и собственного вычислительного оборудования, так и собственных данных для тренировки этих моделей.

Однако с учетом указанных выше принципиальных проблем, ограничений и возможностей, представляет интерес потенциал прорыва как раз в области интерпретируемого ИИ и гибридных нейросимвольных архитектур, где пока сохраняется лидерство российской математической школы, что, в частности, было подтверждено призом за лучшую когнитивную архитектуру, которым была удостоена группа новосибирских разработчиков на международной конференции по общему искусственному интеллекту AGI-2020. При том, что с точки зрения практической применимости данное направление сейчас находится сейчас примерно в том же состоянии, в каком глубокие нейросетевые модели находились 10–15 лет назад, промедление в его практическим развитии может привести к стратегическому отставанию и в этой области.

Наконец, дополнительная возможность «вживую» погрузиться в проблемы и решения в области сильного и общего ИИ представятся участникам конференции AGI-2022, которая в 2022 году, наконец, должна будет пройти в Санкт-Петербурге и безусловно заслуживает внимания всех заинтересованных в данной теме.