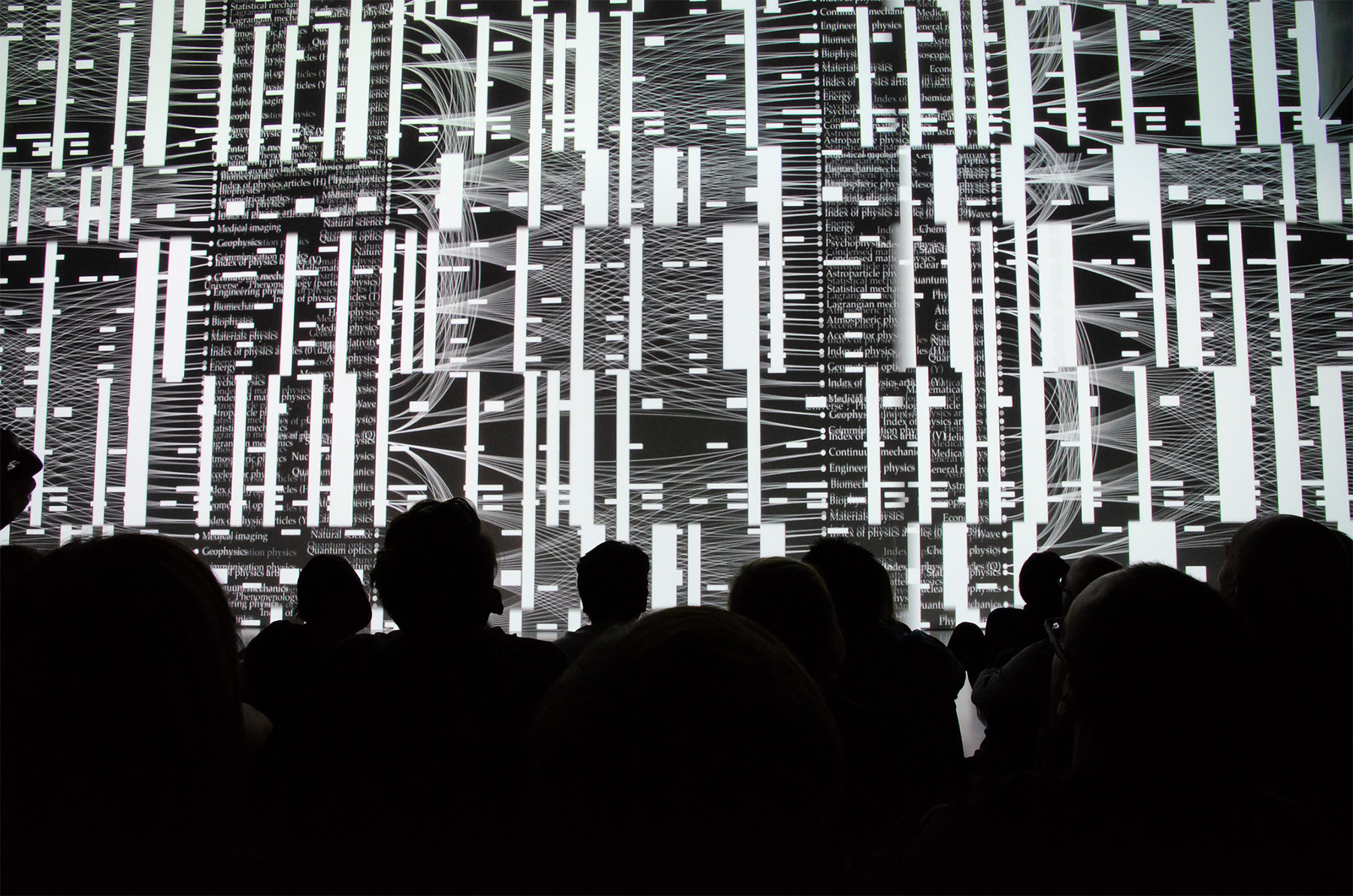

Сколтех 1–3 июля 2020 г. провел онлайн-конференцию Trustworthy AI: Transparency. Robustness. Sustainability. Главной задачей мероприятия, по мнению главы оргкомитета, вице-президента в области ИИ и математического моделирования Максима Федорова, была разработка согласованного подхода для аргументированного разговора о доверии к технологиям ИИ на основе научного языка и междисциплинарной экспертизы.

Вопрос доверия к результатам работы технологий ИИ в своем выступлении наглядно сформулировал профессор Оксфордского университета Питер Гриндрод. Он отметил, что технологии уже сейчас «обгоняют» наше «бытовое» понимание принципов их работы во многих областях применения. Задача специалистов по ИИ — сделать «черный ящик» работы этих систем максимально прозрачным. Профессор Гриндрод добавил, что с точки зрения требований прозрачности больше невозможно полностью полагаться на результаты работы ИИ без понимания механизма принятия решений. Таким образом, надо расширять количество случаев, когда у человека или общества будет право оспорить эти результаты.

Афина Каратцогианни из университета Лестера, в свою очередь, подчеркнула важность перехода вопросов этики и этического образования «в лаборатории», то есть сознательное и специализированное обучение технических специалистов работе в этой области.

Она также отметила, что текущие национальные и наднациональные усилия по стандартизации в сфере ИИ сосредоточены на вопросах рыночной эффективности этих технологий и часто не отвечают на вызовы, которые беспокоят общество. Эксперт предложила своим коллегам-участникам конференции решить вопрос необходимости новых общественных институтов либо возможности переформатирования работы уже существующих органов стандартизации.

Афина Каратцогианни также добавила, что одной из ключевых этических проблем для технологий искусственного интеллекта остается взаимодействие человека и компьютера, поскольку у последнего нет ни социального, ни эмоционального интеллекта. Кроме того, «слепые пятна» человеческого сознания могут стать мишенью для ИИ, не обремененного этическими принципами работы. И для избегания подобных рисков человечеству необходима «координация ценностей».

Наконец, участники конференции акцентировали внимание на наиболее существенной коммуникационной проблеме, связанной с технологиями ИИ: несоответствии видения общества и реального положения вещей. Сегодня в массовом сознании ИИ представляется как полноценный организм, искусственный аналог человеческого мозга (так называемый сильный ИИ, или strong AI). На самом же деле специалисты в области понимают, что на ближайшем горизонте все, что реально делается в плане ИИ, — это слабый ИИ (weak AI). Максим Федоров подчеркнул, что именно из этого несоответствия произрастает большое количество общественных страхов и недоверия людей к ИИ.

Питер Гриндрод резюмировал дискуссию о слабом и сильном ИИ так: «Сейчас мы не видим научного пути, ведущего от слабого ИИ к сильному, поэтому пока неэтично и довольно самонадеянно говорить о сильном ИИ. Сингулярность — это не часть сегодняшней науки, это часть сегодняшней научной фантастики».

Сколтех 1–3 июля 2020 г. провел онлайн-конференцию Trustworthy AI: Transparency. Robustness. Sustainability. Главной задачей мероприятия, по мнению главы оргкомитета, вице-президента в области ИИ и математического моделирования Максима Федорова, была разработка согласованного подхода для аргументированного разговора о доверии к технологиям ИИ на основе научного языка и междисциплинарной экспертизы. Участники конференции обсудили фундаментальные ограничения для таких технологий, подходы к корректировке ошибок, риски использования технологий ИИ в различных областях деятельности, а также фундаментальные проблемы этики и стандартизации ИИ.

Вопрос доверия к результатам работы технологий ИИ в своем выступлении наглядно сформулировал профессор Оксфордского университета Питер Гриндрод. Он отметил, что технологии уже сейчас «обгоняют» наше «бытовое» понимание принципов их работы во многих областях применения. Задача специалистов по ИИ — сделать «черный ящик» работы этих систем максимально прозрачным.

Профессор Гриндрод добавил, что с точки зрения требований прозрачности больше невозможно полностью полагаться на результаты работы ИИ без понимания механизма принятия решений. Таким образом, надо расширять количество случаев, когда у человека или общества будет право оспорить эти результаты. «Когда компьютер говорит “нет” — это более не приемлемый ответ», — сказал ученый.

Он также подчеркнул, что у пользователей технологий ИИ — например, полиции, работающей с алгоритмом распознавания лиц, — также могут быть необоснованные ожидания от их работы. И технологическая демократизация сферы может оказаться «настолько же опасной, насколько и демократизация стоматологии». По мере того, как технологии ИИ получат все больше приложений, роль высокой квалификации людей, которые ими занимаются, должна будет только расти, в том числе и с точки зрения повышения уровня доверия к результатам.

Вовлечение технических специалистов не только в процессы развития самих технологий, но и в общественное обсуждение этических проблем работы с ИИ, также стало одним из центральных вопросов конференции. Профессор Гриндрод подчеркнул, что, например, в Великобритании почти вся обратная связь от общества для регулятора этой сферы представлена «людьми, которые сами не разработали ни одного алгоритма». Это, по его мнению, может вызывать диссонанс в рассмотрении таких проблем.

Максим Федоров считает, что хотя техническое экспертное сообщество начало активно участвовать в работе национальных и международных организаций (например, ЮНЕСКО или ОЭСР), занимающихся вопросами технологий ИИ, необходимо привлекать еще больше технических специалистов для разработки соответствующей нормативной базы. «Важно также координировать и синхронизировать все усилия, чтобы обеспечить эффективную международную кооперацию в области ИИ, а также образования в сфере искусственного интеллекта. Эта конференция станет большим шагом для движения в этом направлении», — сказал Максим Федоров.

Эксперт отметил, что недостаток технической оценки при обсуждениях этики искусственного интеллекта выражается, например, в популярном подходе «естественного отбора», где предлагается опробовать на практике множество технологий ИИ и только потом заниматься их регулированием. Без учета слишком большого количества необратимых рисков, связанных с неосторожным внедрением таких технологий в практику, подход не может считаться надежным.

Афина Каратцогианни из университета Лестера, в свою очередь, подчеркнула важность перехода вопросов этики и этического образования «в лаборатории», то есть сознательное и специализированное обучение технических специалистов работе в этой области. Именно такое обучение планирует добавить в свою образовательную программу Сколтех. Осенью 2020 года в университете откроется кафедра искусственного интеллекта, которая в дальнейшем может получить статус кафедры ЮНЕСКО. По замыслу основателей, она станет международным экспертным центром по проблемам интеграции знаний и технологий ИИ в современное общество. Кроме того, кафедра будет заниматься разработками этических норм и технических стандартов для обеспечения всеобщего доступа к знаниям и технологиям ИИ на основе принципов равенства.

Афина Каратцогианни также отметила, что текущие национальные и наднациональные усилия по стандартизации в сфере ИИ сосредоточены на вопросах рыночной эффективности этих технологий и часто не отвечают на вызовы, которые беспокоят общество. В то же время эти ответы могли бы существенно укрепить общественное доверие. Эксперт предложила своим коллегам-участникам конференции решить вопрос необходимости новых общественных институтов либо возможности переформатирования работы уже существующих органов стандартизации.

Кроме того, участники конференции обсудили вопрос ответственности за решения систем, основанных на технологиях ИИ. Например, может ли искусственный интеллект быть источником информации, которой пользователи будут доверять? Профессор Гриндрод поставил в пример экспертов — людей, имеющих профессиональную репутацию, которая служит источником доверия, и несущих персональную репутационную ответственность за свои рекомендации. В то же время, по словам Гриндрода, искусственный интеллект «не чувствует ответственности за свои рекомендации, не имеет представления о психике другого человека и ничем не рискует». Выработку этических принципов для такой работы технологий ИИ британский эксперт считает важной задачей.

Афина Каратцогианни также добавила, что одной из ключевых этических проблем для технологий искусственного интеллекта остается взаимодействие человека и компьютера, поскольку у последнего нет ни социального, ни эмоционального интеллекта. Кроме того, «слепые пятна» человеческого сознания могут стать мишенью для ИИ, не обремененного этическими принципами работы. И для избегания подобных рисков человечеству необходима «координация ценностей».

Наконец, участники конференции акцентировали внимание на наиболее существенной коммуникационной проблеме, связанной с технологиями ИИ: несоответствии видения общества и реального положения вещей. Сегодня в массовом сознании ИИ представляется как полноценный организм, искусственный аналог человеческого мозга (так называемый сильный ИИ, или strong AI). На самом же деле специалисты в области понимают, что на ближайшем горизонте все, что реально делается в плане ИИ, — это слабый ИИ (weak AI), то есть отдельные технологии, решающие строго прикладные задачи на основе имеющихся у них данных. Такие технологии далеки от полноценных симуляций человеческого мышления. Максим Федоров подчеркнул, что именно из этого несоответствия произрастает большое количество общественных страхов и недоверия людей к ИИ.

Эксперт Сколтеха назвал ключевой проблемой в регулировании ИИ, связанной с его «(сверх)очеловечиванием», восприятие ИИ как «квази-члена» общества. Однако тот комплекс технологий, который мы имеем на сегодняшний день, равно как и в обозримом будущем, никак не может претендовать на такую позицию.

Питер Гриндрод резюмировал дискуссию о слабом и сильном ИИ так: «Сейчас мы не видим научного пути, ведущего от слабого ИИ к сильному, поэтому пока неэтично и довольно самонадеянно говорить о сильном ИИ. Сингулярность — это не часть сегодняшней науки, это часть сегодняшней научной фантастики».